Le Pentagone construit une armée de robots tueurs ou humains nano connecté «conscients de soi» alimentée par les médias sociaux

Des documents officiels de la défense américaine et de l'OTAN confirment que les systèmes d'armes autonomes tueront des cibles, y compris des civils, sur la base de tweets, de blogs et d'Instagram

par Nafeez Ahmed

Cette exclusivité est publiée par INSURGE INTELLIGENCE , un projet de journalisme d'investigation financé par la foule pour le global commons

Un document non classé du ministère de la Défense (DoD), le Human Systems Roadmap Review , révèle que l'armée américaine prévoit de créer des systèmes d'armes autonomes artificiellement intelligents (IA), qui utiliseront des analyses prédictives des médias sociaux pour prendre des décisions sur la force meurtrière avec un minimum de ressources humaines. participation.

Malgré l'insistance officielle sur le fait que les humains conserveront un degré « significatif » de contrôle sur les systèmes d'armes autonomes, ce document et d'autres documents du Pentagone datés de 2015 à 2016 confirment que les planificateurs militaires américains développent déjà des technologies conçues pour permettre à des essaims de robots interconnectés « conscients de soi » pour concevoir et exécuter des opérations d'élimination contre des cibles sélectionnées par le robot.

Plus alarmant encore, les documents montrent que le DoD pense que d'ici quinze ans seulement, il sera possible de déléguer entièrement la planification de mission, la sélection des cibles et le déploiement de la force meurtrière à des systèmes d'armes autonomes dans les airs, les terres et les mers. Le Pentagone s'attend à ce que les évaluations des menaces de l'IA pour ces opérations autonomes soient dérivées d'ensembles de données volumineux, notamment des blogs, des sites Web et des publications multimédias sur des plateformes de médias sociaux comme Twitter, Facebook et Instagram.

L'ensemble de la documentation du Pentagone contredit catégoriquement le démenti du vice-secrétaire à la Défense Robert Work selon lequel le DoD envisage de développer des robots tueurs.

Dans une conversation largement rapportée en mars avec le chroniqueur du Washington Post David Ignatius, Work a déclaré que cela pourrait changer à mesure que les puissances rivales s'efforcent de créer de telles technologies :

"Nous pourrions nous heurter à un concurrent qui est plus disposé que nous à déléguer l'autorité aux machines, et au fur et à mesure que cette compétition se déroulera, nous devrons prendre des décisions sur la meilleure façon de rivaliser."

Mais, a-t-il insisté, "nous ne déléguerons pas l'autorité mortelle à une machine pour prendre une décision", sauf pour la "guerre informatique ou électronique".

Il a menti.

Les documents officiels de la défense américaine et de l'OTAN disséqués par les renseignements d'INSURGE révèlent que les gouvernements occidentaux envisagent déjà de développer des systèmes d'armes autonomes capables de prendre des décisions sur la force meurtrière - et que de tels systèmes, à l'avenir, devraient même prendre des décisions à des niveaux acceptables. de « dommages collatéraux ».

Derrière les discours publics, une course aux armements secrète

Les efforts pour créer des tueurs de robots autonomes ont évolué au cours de la dernière décennie, mais ont atteint leur paroxysme cette année.

Une conférence de la National Defence Industry Association (NDIA) sur les capacités de robotique au sol en mars a accueilli des représentants du gouvernement et des dirigeants de l'industrie confirmant que le Pentagone développait des équipes de robots capables d'utiliser une force meurtrière sans instruction d'opérateurs humains.

En avril, des représentants du gouvernement et des ONG internationales se sont réunis aux Nations Unies à Genève pour discuter des questions juridiques et éthiques entourant les systèmes d'armes létales autonomes (LAWS).

Ce mois-là, le gouvernement britannique a lancé une enquête parlementaire sur la robotique et l'IA. Et plus tôt en mai, le Bureau de la science et de la technologie de la Maison Blanche a annoncé une série d'ateliers publics sur les vastes implications sociales et économiques de l'IA.

La plupart des médias ont rapporté le fait que jusqu'à présent, les gouvernements n'ont pas exclu la possibilité à long terme que des robots intelligents puissent éventuellement être autorisés à prendre des décisions pour tuer des cibles humaines de manière autonome.

Mais contrairement à l'affirmation de Robert Work, des efforts de recherche et développement actifs pour explorer cette possibilité sont déjà en cours. Les plans peuvent être glanés à partir de plusieurs documents non classifiés du Pentagone dans les archives publiques qui sont passés inaperçus jusqu'à présent.

Parmi eux se trouve un document publié en février 2016 par la communauté d'intérêt des systèmes humains (HSCOI) du Pentagone.

Le document montre non seulement que le Pentagone crée activement des systèmes d'armes autonomes létaux, mais qu'un élément crucial du processus de prise de décision pour de tels systèmes robotiques comprendra des modèles complexes de Big Data, dont l'une des entrées sera les publications sur les réseaux sociaux.

Des robots qui tuent « comme les gens »

Le HSCOI est un réseau de recherche et de développement multi-agences peu connu créé par le Bureau du secrétaire à la Défense (OSD), qui agit comme une plaque tournante pour une énorme pléthore de travaux scientifiques et technologiques dans les agences militaires et de renseignement américaines.

Le document est une présentation de 53 pages préparée par le président du HSCOI, le Dr John Tangney, directeur de la division des systèmes humains et bio-ingénierie de l'Office of Naval Research. Intitulées Examen de la feuille de route des systèmes humains , les diapositives ont été présentées lors de la conférence sur les systèmes humains de la NDIA en février.

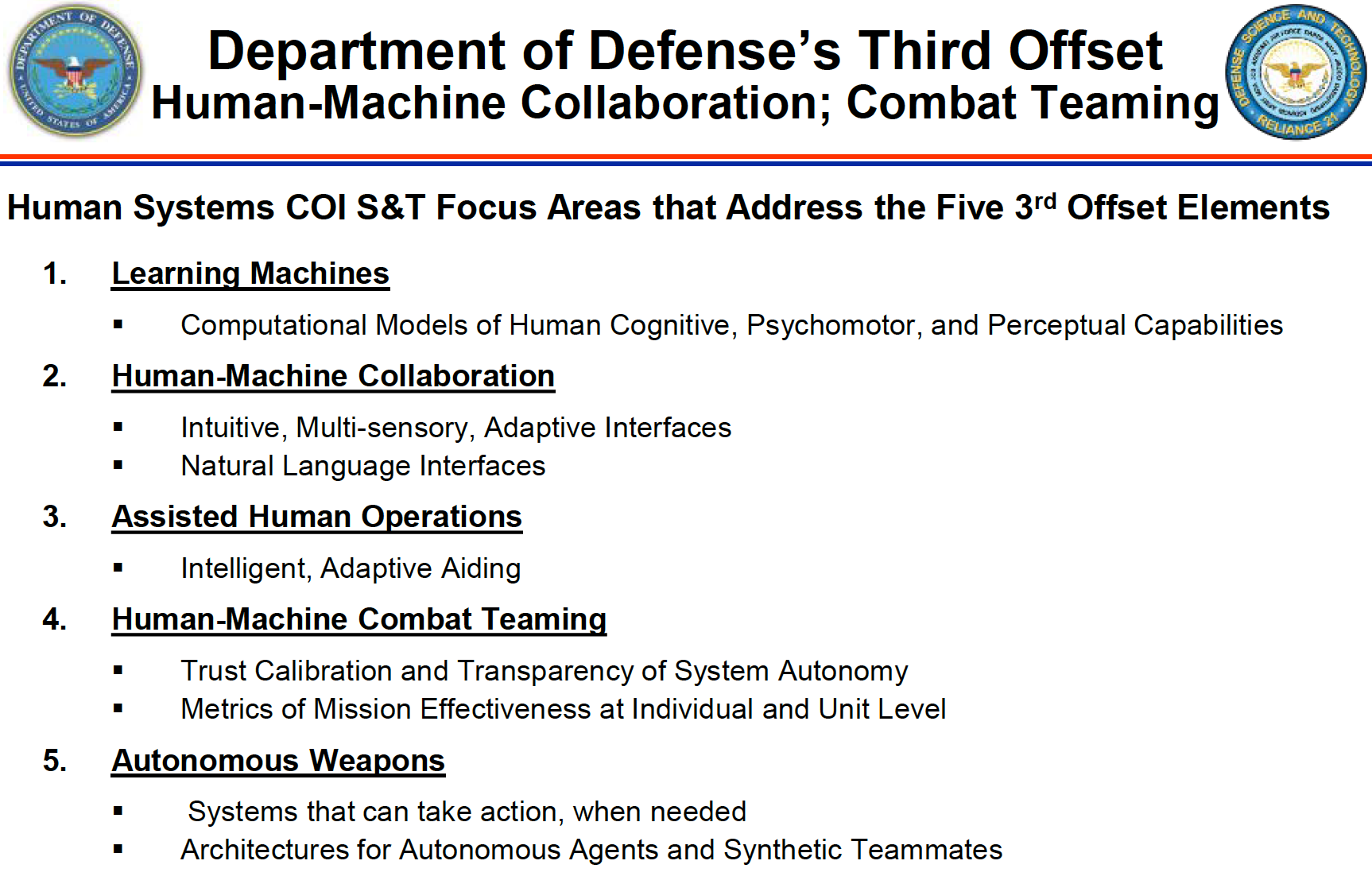

Le document indique que l'un des cinq « blocs de construction » du programme des systèmes humains consiste à « activer le réseau, des armes autonomes durcies pour fonctionner dans un futur environnement Cyber / EW [guerre électronique] ». Cela permettrait de « concepts d'armes coopératifs dans des environnements où les communications sont interdites ».

Mais ensuite, le document va plus loin, identifiant des «domaines d'intervention» pour le développement de la science et de la technologie comme «Armes autonomes: des systèmes qui peuvent agir, en cas de besoin», ainsi que «Architectures pour agents autonomes et coéquipiers synthétiques».

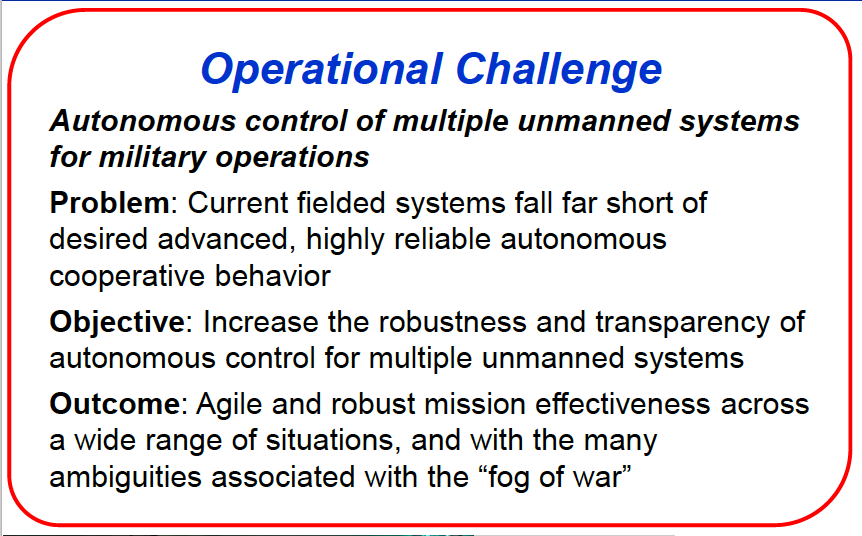

L'objectif final est la mise en place d'un "contrôle autonome de plusieurs systèmes sans pilote pour les opérations militaires".

De tels systèmes autonomes doivent être capables de sélectionner et d'engager des cibles par eux-mêmes - avec un « contrôle » humain considérablement réduit au minimum pour affirmer que l'opération reste dans les paramètres de « l'intention » du commandant.

Le document affirme explicitement que ces nouveaux systèmes d'armes autonomes devraient être capables de répondre aux menaces sans intervention humaine, mais d'une manière qui simule le comportement et la cognition humains.

Le programme HSCOI du DoD doit « combler le fossé entre les simulations haute fidélité de la cognition humaine dans les tâches de laboratoire et les environnements complexes et dynamiques ».

Se référant aux « Mécanismes de traitement cognitif » des systèmes autonomes, le document met en évidence la nécessité de :

« Mécanismes plus robustes, valides et intégrés qui permettent à des agents constructifs de penser et d'agir vraiment comme des personnes. »

L'objectif ultime du Pentagone est de développer un « contrôle autonome de plusieurs systèmes d'armes avec moins de personnel » en tant que « multiplicateur de force ».

Les nouveaux systèmes doivent afficher « un comportement coopératif autonome hautement fiable » pour permettre « une efficacité de mission agile et robuste dans un large éventail de situations, et avec les nombreuses ambiguïtés associées au « brouillard de la guerre ».

Ressusciter le terrain humain

Le HSCOI est composé de hauts fonctionnaires de l'US Army, Navy, Marine Corps, Air Force, Defence Advanced Research Projects Agency (DARPA) ; et est supervisé par le secrétaire adjoint à la Défense pour la recherche et l'ingénierie et le secrétaire adjoint à la Défense pour les affaires de santé.

Le travail de HSCOI va bien au-delà de la simple création de systèmes d'armes autonomes. Une partie intégrante de cela consiste à faire progresser simultanément les interfaces homme-machine et l'analyse prédictive.

Ce dernier comprend ce qu'une brochure HSCOI pour l'industrie technologique, « Défis, opportunités et efforts futurs », décrit comme la création de « modèles de prédiction des menaces à base sociale » dans le cadre de « l'ISR de l'activité humaine ».

C'est un raccourci pour le renseignement, la surveillance et la reconnaissance d'une population dans une `` zone d'intérêt '', en collectant et en analysant des données sur les comportements, la culture, la structure sociale, les réseaux, les relations, la motivation, l'intention, les vulnérabilités et les capacités d'un groupe humain.

L'idée, selon la brochure, est de rassembler des données open source provenant d'un large éventail, y compris des sources de médias sociaux, dans une seule interface analytique qui peut « afficher la connaissance des croyances, des attitudes et des normes qui motivent dans des environnements incertains ; utiliser ces connaissances pour élaborer des plans d'action pour atteindre l'intention du commandant et minimiser les conséquences imprévues ; [et] construire des modèles pour permettre des prévisions précises des événements prédits.

Le document Human Systems Roadmap Review de février 2016 montre que ce domaine de développement est un héritage du programme controversé de « terrain humain » du Pentagone.

Le système de terrain humain (HTS) était un programme de commandement de la formation et de la doctrine de l'armée américaine (TRADOC) créé en 2006, qui a intégré des spécialistes des sciences sociales sur le terrain pour augmenter les opérations de contre-insurrection dans des théâtres comme l'Irak et l'Afghanistan.

L'idée était d'utiliser des spécialistes des sciences sociales et des anthropologues culturels pour fournir à l'armée américaine un aperçu exploitable des populations locales afin de faciliter les opérations - en d'autres termes, pour armer les sciences sociales.

Le programme de 725 millions de dollars a été fermé en septembre 2014 à la suite d'une controverse croissante sur sa pure incompétence.

Le programme HSCOI qui le remplace comprend les sciences sociales, mais l'accent est désormais mis davantage sur leur combinaison avec des modèles informatiques prédictifs basés sur le Big Data. La brochure évalue à 450 millions de dollars le budget projeté du nouveau projet de systèmes humains.

L' examen de la feuille de route des systèmes humains du Pentagone démontre que loin d'être éliminé, le paradigme HTS a été mis à niveau dans le cadre d'un programme multi-agences plus large qui implique l'intégration de l'analyse Big Data avec des interfaces homme-machine et, finalement, des systèmes d'armes autonomes.

La nouvelle science de l'observation de la boule de cristal des médias sociaux

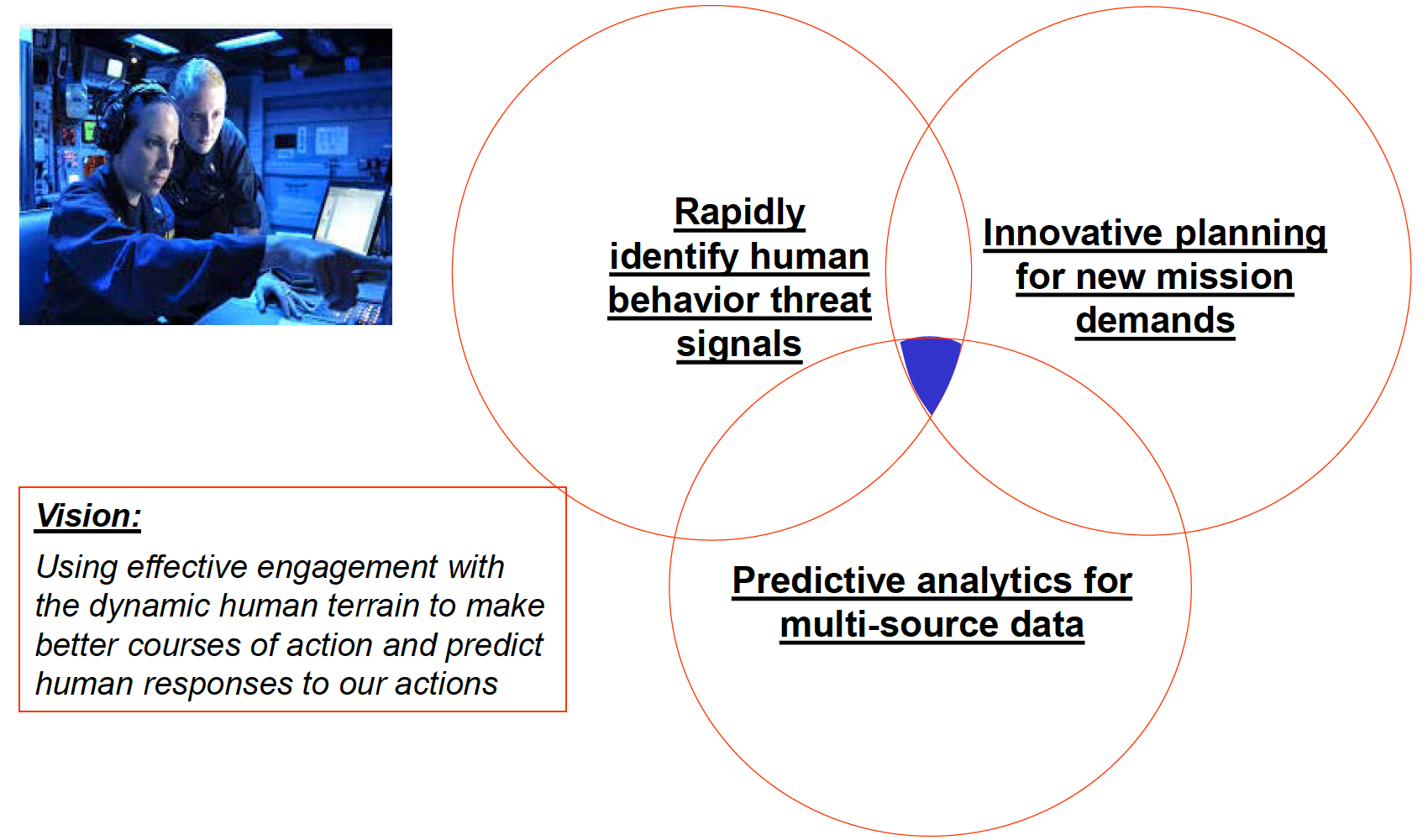

La feuille de route des systèmes humains de 2016 explique que la «vision» du Pentagone est d'utiliser «un engagement efficace avec le terrain humain dynamique pour élaborer de meilleurs plans d'action et prédire les réponses humaines à nos actions» sur la base de «l'analyse prédictive des données multi-sources».

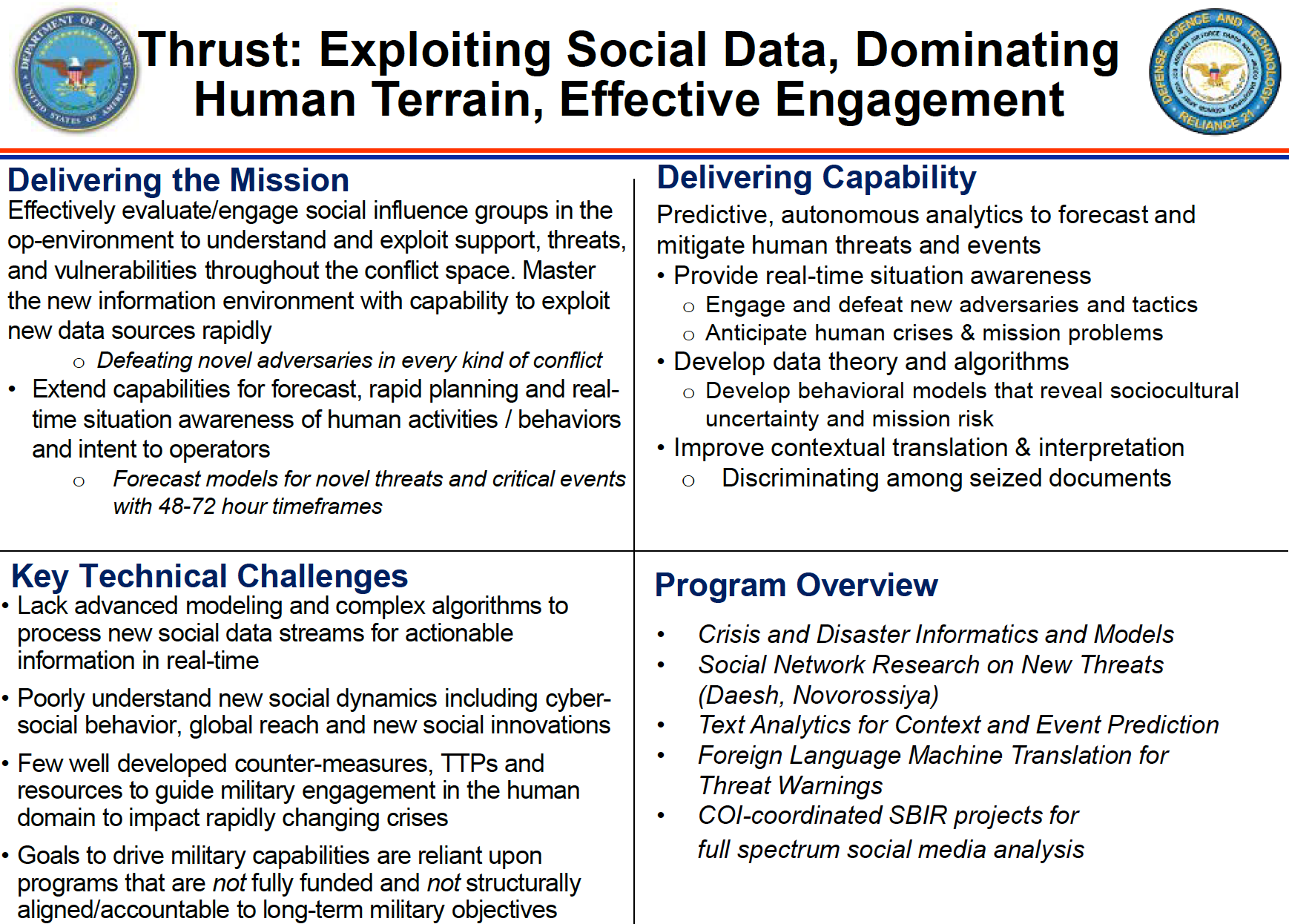

Dans une diapositive intitulée « Exploiting Social Data, Domming Human Terrain, Effective Engagement », le document fournit plus de détails sur les objectifs du Pentagone :

« Évaluez / engagez efficacement les groupes d'influence sociale dans l'environnement opérationnel pour comprendre et exploiter le soutien, les menaces et les vulnérabilités dans l'espace de conflit. Maîtrisez le nouvel environnement de l'information avec la capacité d'exploiter rapidement de nouvelles sources de données.

Le Pentagone veut s'appuyer sur des référentiels massifs de données open source pouvant prendre en charge «des analyses prédictives et autonomes pour prévoir et atténuer les menaces et les événements humains».

Cela signifie non seulement développer des « modèles comportementaux qui révèlent l'incertitude socioculturelle et le risque de mission », mais créer des « modèles de prévision pour les nouvelles menaces et les événements critiques avec des délais de 48 à 72 heures », et même établir une technologie qui utilisera ces données pour « fournir de véritables conscience de la situation dans le temps.

Selon le document, "l'analyse complète des médias sociaux" doit jouer un rôle énorme dans cette modélisation, pour soutenir "I/W [guerre irrégulière], les opérations d'information et les communications stratégiques".

Celui-ci se décompose en trois domaines principaux :

« Analyse prédictive des médias ; Récupération de texte et de vidéo basée sur le contenu ; Exploitation des médias sociaux à des fins d'intelligence.

Le document fait référence à l'utilisation des données des médias sociaux pour prévoir les menaces futures et, sur cette base, élaborer automatiquement des recommandations pour un « plan d'action » (CoA).

Sous le titre « Analyse des signaux faibles et analyse des réseaux sociaux pour la prévision des menaces », le Pentagone souligne la nécessité de :

« Développez une compréhension en temps réel du contexte incertain avec des outils à faible coût faciles à former, réduisez la charge de travail des analystes et informez la sélection/l'analyse du [plan d'action] COA. »

En d'autres termes, la contribution humaine au développement de la « sélection/analyse » du plan d'action doit être de plus en plus réduite et remplacée par des modèles analytiques prédictifs automatisés qui s'appuient largement sur les données des médias sociaux.

Cela peut même être utilisé pour informer les soldats des menaces en temps réel en utilisant la réalité augmentée pendant les opérations. Le document fait référence à «la fusion des médias sociaux pour alerter les soldats à la pointe de la tactique» et à la «reconnaissance de la personne d'intérêt et des relations associées».

L'idée est d'identifier des cibles potentielles — des « personnes d'intérêt » — et leurs réseaux, en temps réel, en utilisant les données des médias sociaux comme « intelligence ».

Un contrôle humain significatif sans humains

Les gouvernements américain et britannique tentent donc rapidement de redéfinir « le contrôle humain » et « l'intention humaine » dans le contexte des systèmes autonomes.

Parmi les problèmes qui ont émergé lors des réunions de l'ONU en avril, il y a la tendance à diluer les paramètres qui permettraient de décrire un système d'arme autonome comme étant lié à un contrôle humain « significatif ».

Un document distinct du Pentagone daté de mars 2016 - un ensemble de diapositives de présentation pour la conférence IEEE de ce mois-ci sur les méthodes cognitives dans la sensibilisation aux situations et l'aide à la décision - insiste sur le fait que la politique du DoD est de garantir que les systèmes autonomes fonctionnent finalement sous la supervision humaine:

« [Les] principaux avantages des capacités autonomes sont d'étendre et de compléter les performances humaines, pas nécessairement de remplacer directement les humains. »

Malheureusement, il y a un "mais".

Le document de mars, Autonomous Horizons: System Autonomy in the Air Force , a été rédigé par le Dr Greg Zacharias, scientifique en chef de l'US Air Force. La conférence IEEE où elle a été présentée était parrainée par deux principaux sous-traitants gouvernementaux de la défense, Lockheed Martin et United Technologies Corporation, entre autres mécènes.

D'autres passages du document sont révélateurs:

« Les décisions autonomes peuvent conduire à des actions à grand regret, en particulier dans des environnements incertains. »

En particulier, le document observe:

« Certaines activités du DoD, telles que l'application de la force, se produiront dans des environnements complexes, imprévisibles et contestés. Le risque est élevé.

La solution, soi-disant, est de concevoir des machines qui, fondamentalement, pensent, apprennent et résolvent des problèmes comme les humains. Un système d'IA autonome doit « être conforme à la façon dont les humains analysent le problème » et guidé par « des processus de gestion des connaissances d'aide/d'automatisation selon la façon dont les humains résolvent le problème [sic] ».

Une section intitulée « AFRL [Air Force Research Laboratory] Roadmap for Autonomy » montre ainsi comment d'ici 2020, l'US Air Force envisage « les opérations assistées par machine comprimant la chaîne de destruction ». Le bas de la diapositive indique :

"Des décisions à la vitesse de l'informatique."

Cette « chaîne d'élimination » en deux étapes se décompose comme suit : premièrement, « le gestionnaire du système défensif [manager] identifie les menaces et recommande des actions » ; deuxièmement, «le système analytique du renseignement fusionne les données INT [intelligence] et l'analyste d'indices des menaces.»

Dans cette structure, un système d'arme autonome létal s'appuie sur des données de renseignement pour identifier une menace, qu'un analyste « identifie simplement » avant de recommander « une action ».

Commentaires

Enregistrer un commentaire